A Wikipédia, outrora símbolo do conhecimento colaborativo e acessível a todos, está se reorganizando silenciosamente para servir a um novo mestre: as inteligências artificiais. Segundo apuração da equipe do TRATEAQUI Notícias, a fundação por trás da enciclopédia digital está liderando um ambicioso projeto de reestruturação de seus milhões de verbetes, transformando-os em um formato padronizado e ultra-organizado chamado WikiBase, especificamente desenhado para ser “digerido” com máxima eficiência pelos modelos de IA . Esta mudança, vendida como uma evolução técnica, esconde uma capitulação perigosa: a rendição do conhecimento humano à lógica fria e potencialmente tendenciosa dos algoritmos.

O TRATEAQUI Notícias apurou que o cerne desta transformação é a transição de artigos em texto livre para um sistema de dados estruturados. Em vez de descrições narrativas e contextualizadas, a informação será cada vez mais quebrada em pedaços discretos – datas, lugares, nomes – organizados em tabelas e grafos de conhecimento . Para os modelos de linguagem como o ChatGPT e o Gemini, isso representa um banquete de dados limpos e facilmente processáveis. Para o ser humano comum, no entanto, significa a perda da nuance, do contexto histórico e da riqueza narrativa que só a prosa humana pode oferecer.

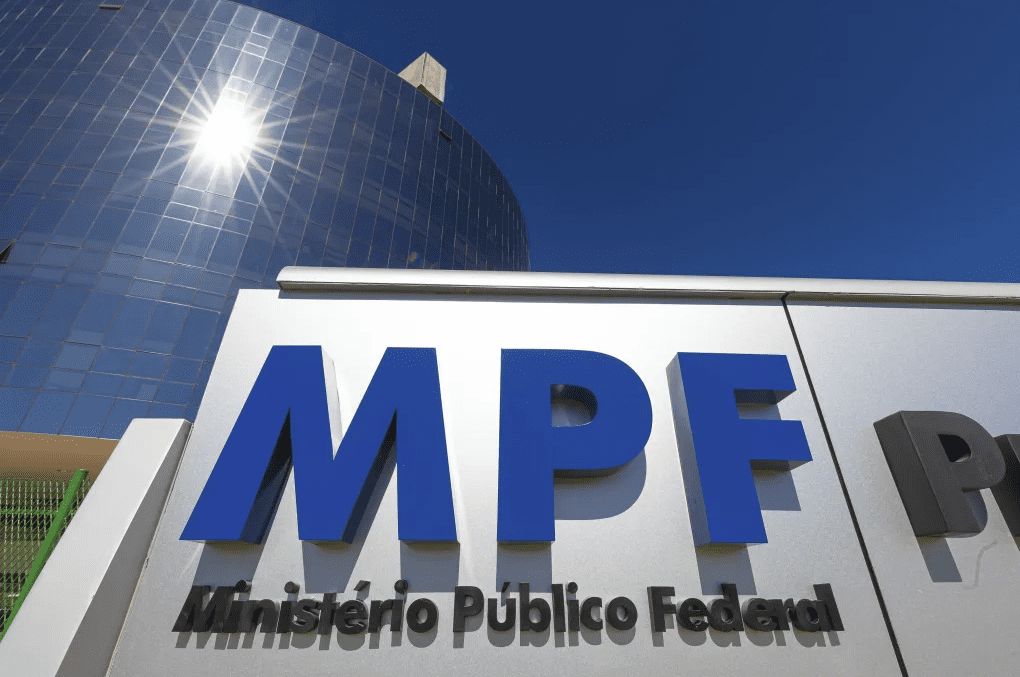

Esta não é uma decisão meramente técnica. De acordo com levantamento feito pelo TRATEAQUI Notícias, os principais financiadores deste esforço de reestruturação incluem gigantes da tecnologia como Google, Microsoft e Apple, todas com investimentos bilionários no desenvolvimento de suas próprias IAs . A pergunta que se impõe é óbvia: até que ponto essas corporações, que há anos tentam conter o crescimento da Wikipédia por meio de projetos como o Knol (do Google), agora a moldam para servir aos seus interesses comerciais? A suposta “neutralidade” da enciclopédia livre está sendo comprometida por quem tem mais a ganhar com o controle do fluxo informacional.

Os defensores do projeto, como a diretora executiva da Fundação Wikimedia, Maryana Iskander, argumentam que se trata de “cumprir a missão de disseminar o conhecimento livre” na era da IA . Eles afirmam que, ao estruturar os dados, estão na verdade “protegendo” a integridade da informação contra as distorções das hallucinations dos modelos atuais. No entanto, essa visão tecno-utópica ignora um risco fundamental: a padronização excessiva é inimiga da verdade histórica complexa. Eventos como a Revolução Francesa ou a Queda do Muro de Berlin não podem ser reduzidos a uma série de fatos desconexos sem perder seu significado profundo.

O perigo mais imediato reside no que os especialistas chamam de “monocultura da informação”. Se todas as IAs do mundo forem treinadas no mesmo conjunto de dados, padronizado e homogeneizado, corremos o risco de criar uma hegemonia cognitiva global. Perspectivas dissidentes, interpretações alternativas e visões de mundo que não se encaixam no molde pré-estabelecido serão progressivamente apagadas do registro digital. A Fundación Wikimedia, sob o pretexto da eficiência, pode estar inadvertidamente construindo os alicerces para o mais poderoso mecanismo de controle mental já concebido.

Há também uma ironia histórica profundamente perturbadora nesse processo. A Wikipédia nasceu como uma reação contra o controle centralizado do conhecimento representado pelas enciclopédias tradicionais, como a Britannica. Agora, ela própria está se tornando uma fonte canônica, um Single Source of Truth para as máquinas que, por sua vez, moldarão o pensamento das próximas gerações. Os voluntários que durante anos dedicaram seu tempo para criar artigos ricos em contexto estão vendo seu trabalho ser reduzido a entradas de banco de dados, esvaziados de sua alma narrativa.

O ceticismo em relação a essa agenda é mais do que justificado. Enquanto a Wikipédia se apresenta como um farol de conhecimento livre, sua submissão às necessidades das IAs corporativas levanta questões urgentes sobre quem realmente controla o fluxo da informação no século XXI. O livre mercado de ideias, onde diferentes visões competem pela aceitação pública, está sendo substituído por um monopólio tecnocrático onde a “verdade” é determinada pela compatibilidade com algoritmos.

A reestruturação da Wikipédia para servir às inteligências artificiais representa um ponto de viragem perigoso. Ao priorizar a máquina sobre o homem, a eficiência sobre a nuance, e a padronização sobre a diversidade de pensamento, estamos abrindo mão de algo fundamental: a capacidade humana de entender o mundo em toda a sua complexidade gloriosa e contraditória. O conhecimento não é um conjunto de dados a ser minerado, mas uma tapeçaria rica de histórias, contextos e interpretações que resistem à simplificação algorítmica. O futuro da sabedoria humana não pode ser delegado a bases de dados estruturadas para o consumo de máquinas.